Google améliore son chatbot Gemini basé sur l’IA afin qu’il puisse mieux comprendre le monde qui l’entoure et les personnes qui discutent avec lui.

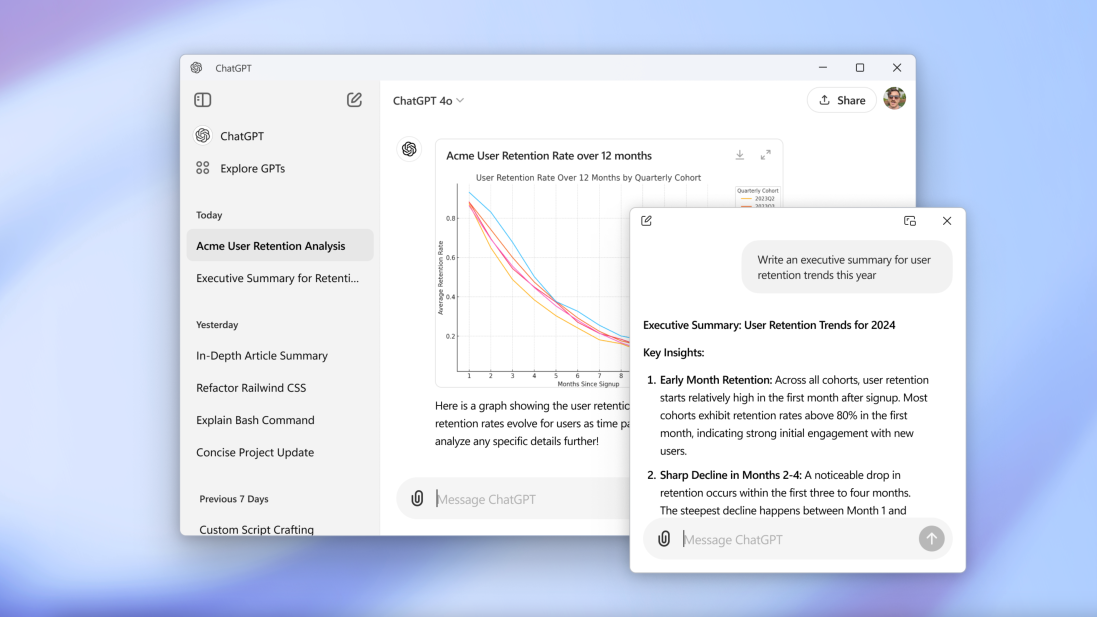

Lors de la conférence des développeurs Google I/O 2024 mardi, la société a présenté en avant-première une nouvelle expérience dans Gemini appelée Gemini Live, qui permet aux utilisateurs d’avoir des discussions vocales « approfondies » avec Gemini sur leurs smartphones. Les utilisateurs peuvent interrompre Gemini pendant que le chatbot parle pour poser des questions de clarification, et celui-ci s’adaptera à leurs modèles de parole en temps réel. Et Gemini peut voir et réagir à l’environnement des utilisateurs, soit via des photos ou des vidéos capturées par les caméras de leurs smartphones.

« Avec Live, Gemini peut mieux vous comprendre », a déclaré Sissie Hsiao, directrice générale des expériences Gemini chez Google, lors d’un point de presse. « Il est personnalisé pour être intuitif et avoir une conversation réelle avec le modèle [d’IA sous-jacent]. »

Gemini Live est en quelque sorte l’évolution de Google Lens , la plate-forme de vision par ordinateur de longue date de Google pour analyser des images et des vidéos, et de Google Assistant , l’assistant virtuel de Google, alimenté par l’IA, générant et reconnaissant la parole sur les téléphones, les haut-parleurs intelligents et les téléviseurs.

À première vue, Live ne semble pas être une mise à niveau radicale par rapport à la technologie existante. Mais Google affirme qu’il exploite des techniques plus récentes du domaine de l’IA générative pour fournir une analyse d’image supérieure et moins sujette aux erreurs – et combine ces techniques avec un moteur vocal amélioré pour un dialogue à plusieurs tours plus cohérent, émotionnellement expressif et réaliste.

« Il s’agit d’une interface vocale en temps réel dotée de capacités multimodales extrêmement puissantes combinées à un contexte long », a déclaré Oriol Vinyals, scientifique principal chez DeepMind, la division de recherche sur l’IA de Google, à TechCrunch dans une interview. « Vous pouvez imaginer à quel point cette combinaison sera très puissante. »

Les innovations techniques qui animent Live proviennent en partie du projet Astra, une nouvelle initiative au sein de DeepMind visant à créer des applications et des « agents » basés sur l’IA pour une compréhension multimodale en temps réel.

« Nous avons toujours voulu créer un agent universel qui serait utile dans la vie de tous les jours », a déclaré Demis Hassabis, PDG de DeepMind, lors du briefing. « Imaginez des agents capables de voir et d’entendre ce que nous faisons, de mieux comprendre le contexte dans lequel nous nous trouvons et de répondre rapidement aux conversations, ce qui rend le rythme et la qualité des interactions beaucoup plus naturels. »

Gemini Live – qui ne sera lancé que plus tard cette année – peut répondre à des questions sur les éléments visibles (ou récemment visibles) de la caméra d’un smartphone, comme le quartier dans lequel un utilisateur pourrait se trouver ou le nom d’une pièce sur un vélo cassé. Pointé vers une partie du code informatique, Live peut expliquer ce que fait ce code. Ou, lorsqu’on lui demande où se trouve une paire de lunettes, Live peut dire où il a « vu » les lunettes pour la dernière fois.

Live est également conçu pour servir de coach virtuel, aidant les utilisateurs à répéter des événements, à réfléchir à des idées, etc. Live peut suggérer les compétences à mettre en valeur lors d’un prochain entretien d’embauche ou de stage, par exemple, ou donner des conseils pour prendre la parole en public.

« Gemini Live peut fournir des informations de manière plus succincte et répondre de manière plus conversationnelle que, par exemple, si vous interagissez uniquement par texte », a déclaré Sissie. « Nous pensons qu’un assistant IA doit être capable de résoudre des problèmes complexes… et également se sentir très naturel et fluide lorsque vous l’utilisez. »

La capacité de Gemini Live à « se souvenir » est rendue possible par l’architecture du modèle qui le sous-tend : Gemini 1.5 Pro (et dans une moindre mesure d’autres modèles génératifs « spécifiques à des tâches »), qui est le produit phare actuel de la famille Gemini d’IA générative de Google. des modèles. Il a une fenêtre contextuelle plus longue que la moyenne, ce qui signifie qu’il peut absorber et raisonner de nombreuses données – environ une heure de vidéo (RIP, batteries de smartphone) – avant d’élaborer une réponse.

« Cela représente des heures de vidéo pendant lesquelles vous pourriez interagir avec le modèle, et il se souviendrait de tout ce qui s’est passé auparavant », a déclaré Vinyals.

Live rappelle l’IA générative derrière les lunettes Ray-Ban de Meta , qui peuvent également regarder les images capturées par une caméra et les interpréter en temps quasi réel. À en juger par les démos préenregistrées que Google a montrées lors du briefing, il est également assez similaire – de manière évidente – au ChatGPT récemment réorganisé d’OpenAI .

L’une des principales différences entre le nouveau ChatGPT et Gemini Live est que Gemini Live ne sera pas gratuit. Une fois lancé, Live sera exclusif à Gemini Advanced, une version plus sophistiquée de Gemini protégée par le forfait Google One AI Premium, au prix de 20 $ par mois.

Peut-être lors d’une conversation avec Meta, l’une des démos de Google montrait une personne portant des lunettes AR équipées d’une application de type Gemini Live. Google – sans doute désireux d’éviter un autre raté dans le département des lunettes – a refusé de dire si ces lunettes ou des lunettes alimentées par son IA générative seraient commercialisées dans un avenir proche.

Vinyals n’a cependant pas complètement abandonné l’idée. « Nous sommes toujours en train de prototyper et, bien sûr, de présenter [Astra et Gemini Live] au monde », a-t-il déclaré. « Nous voyons la réaction des gens qui peuvent l’essayer, et cela nous indiquera où nous allons. »

Autres mises à jour de Gemini

Au-delà de Live, Gemini bénéficie d’une série de mises à niveau pour le rendre plus utile au quotidien.

Les utilisateurs de Gemini Advanced dans plus de 150 pays et dans plus de 35 langues peuvent profiter du contexte plus large de Gemini 1.5 Pro pour que le chatbot analyse, résume et réponde aux questions sur des documents longs (jusqu’à 1 500 pages). (Bien que Live arrive plus tard dans l’année, les utilisateurs de Gemini Advanced peuvent interagir avec Gemini 1.5 Pro à partir d’aujourd’hui.) Les documents peuvent désormais être importés depuis Google Drive ou téléchargés directement depuis un appareil mobile.

Plus tard cette année, pour les utilisateurs de Gemini Advanced, la fenêtre contextuelle s’agrandira encore plus – jusqu’à 2 millions de jetons – et apportera la prise en charge du téléchargement de vidéos (jusqu’à deux heures) sur Gemini et de l’analyse par Gemini de bases de code volumineuses (plus de 30 000 lignes). de code).

Google affirme que la grande fenêtre contextuelle améliorera la compréhension des images de Gemini. Par exemple, à partir d’une photo d’un plat de poisson, les Gémeaux pourront proposer une recette comparable. Ou, face à un problème mathématique, Gemini fournira des instructions étape par étape sur la façon de le résoudre.

Et cela aidera les Gémeaux à planifier leur voyage.

Dans les mois à venir, Gemini Advanced bénéficiera d’une nouvelle « expérience de planification » qui créera des itinéraires de voyage personnalisés à partir d’invites. En tenant compte d’éléments tels que les horaires de vol (à partir des e-mails dans la boîte de réception Gmail d’un utilisateur), les préférences alimentaires et les informations sur les attractions locales (à partir des données de recherche Google et Maps), ainsi que les distances entre ces attractions, Gemini générera un itinéraire qui se mettra automatiquement à jour. pour refléter tout changement.

Dans un avenir plus immédiat, les utilisateurs de Gemini Advanced pourront créer des Gems, des chatbots personnalisés alimentés par les modèles Gemini de Google. À l’instar des GPT d’OpenAI, les gemmes peuvent être générées à partir de descriptions en langage naturel, par exemple : « Vous êtes mon entraîneur de course à pied. Donnez-moi un plan de course quotidien » – et partagé avec d’autres ou gardé privé. On ne sait pas si Google envisage de lancer une vitrine pour Gems comme le GPT Store d’OpenAI ; j’espère que nous en apprendrons davantage au fur et à mesure des E/S.

Bientôt, Gems et Gemini proprement dits pourront exploiter un ensemble étendu d’intégrations avec les services Google, notamment Google Calendar, Tasks, Keep et YouTube Music, pour effectuer diverses tâches permettant d’économiser du travail.

« Disons que vous avez un dépliant de l’école de votre enfant et que vous souhaitez ajouter tous ces événements à votre calendrier personnel », a déclaré Hsiao. « Vous pourrez prendre une photo de ce dépliant et demander à l’application Gemini de créer ces entrées de calendrier directement sur votre calendrier. Cela va nous faire gagner beaucoup de temps.

Étant donné la tendance de l’IA générative à se tromper dans les résumés et à dérailler généralement (plus les premières critiques pas si élogieuses de Gemini ), prenez les affirmations de Google avec des pincettes. Mais si les Gemini et Gemini Advanced améliorés fonctionnent réellement comme le décrit Hsiao – et c’est un grand si – ils pourraient en effet faire gagner beaucoup de temps.